1 基本概念

1.1 概率空间

离散概率空间 (Ω,Pr) 由一个非空可数集合 Ω 和定义在其上的 概率质量函数(pmf)Pr:Ω→R 组成。要求 ∀ω∈Ω,Pr[ω]≥0 且 ∑ω∈ΩPr[ω]=1。每一个 ω∈Ω 被称为一个 样本点。

1.2 事件

事件是非空可数集合 Ω 的一个子集(因此也必然是可数的)。事件 A 发生的概率被定义为: Pr[A]:=∑ω∈APr[ω] 事件的组合通常用逻辑运算符号来描述,如 A∧B,A∨B,¬A 等。下面给出了事件组合的一些性质:

-

相交:如果 A∧B=∅,那么我们称事件 A 和 B 是不相交的(disjoint);否则事件 A 和 B 相交。

-

独立:事件 A 和 B 是独立的(independent)当且仅当 Pr[A∧B]=Pr[A]⋅Pr[B]。

-

相互独立:事件的集合 {Ai∣i∈I} 相互独立(fully / mutually independent)当且仅当 Pr[n⋀i=1Ai]=n∏i=1Pr[Ai]

-

成 k 对独立:如果事件的集合 {Ai∣i∈I} 的每一个由 k 个事件组成的子集都是相互独立的,则称 {Ai∣i∈I} 是成 k 对独立的(k-wise independent);当 k=2 时,我们称 {Ai∣i∈I} 是成对独立的(pairwise independent)。若 ∀k 均有 {Ai∣i∈I} 是成 k 对独立的,则 {Ai∣i∈I} 是相互独立的。

-

条件概率:对于任意两个事件 A 和 B 且 Pr[B]>0,则在 B 发生的条件下 A 发生的概率为 Pr[A∣B]=Pr[A∧B]Pr[B]

1.3 组合事件的一些恒等式

-

Union Bound:对于任意事件 A1,A2,...,An 有 Pr[n⋀i=1Ai]≤n∏i=1Pr[Ai]

-

Disjoint Union:如果事件 A1,A2,...,An 是成对不相容的,即 ∀i≠j,Ai∧Aj=∅,则 Pr[n⋁i=1Ai]=n∑i=1Pr[Ai]

-

The Principle of Inclusion-Exclusion:对于任意有穷事件集合 {A1,A2,...,An},有 Pr[n⋁i=1Ai]=1−∑I⊆{1,...,n}(−1)|I|Pr[⋀i∈IAi] 当 n=2 时,有 Pr[A∨B]=Pr[A]+Pr[B]−(Pr[A∧B])

-

Independent Union:如果有穷事件集合 {A1,A2,...,An} 是相互独立的, Pr[n⋁i=1Ai]=1−n∏i=1(1−Pr[Ai]) 当 n=2 时,有 Pr[A∨B]=1−(1−Pr[A])(1−Pr[B])

-

Bayes’ Theorem:对于任意事件 A 和 B,如果 Pr[A]≠0,Pr[B]≠0,则根据条件概率的定义可得 Pr[A∣B]Pr[B]=Pr[A∧B]=Pr[A]⋅Pr[B]=Pr[B∣A]Pr[A]

-

Law of Total Probability:设 {Bn:n=1,2,...} 是概率空间 Ω 的有限或可数无限的分隔,且每个集合可数,则对任意事件 A 有 Pr[A]=∑nPr[A∧Bn]=∑nPr[A∣Bn]Pr[Bn]

1.4 随机变量

随机变量 X 是一个从 Ω 到某个数值集合 V 的一个映射:X(ω∈Ω)=x∈V。随机变量既不随机,也不是一个变量,而是一个函数。 显然,有 Pr[X=x]=Pr[A:={ω∈Ω∣X(ω)=x}] 定义在随机变量上的任意概念总应当回归到事件这一底层概念上去理解。

随机变量 X 的(累积)分布函数 CDF 如下: CDFX(X≤x)=Pr[X≤x]=Pr[A:={ω∈Ω∣X(ω)≤x}]

1.5 期望

定义在随机变量 X 上的期望为: (离散)E[X]:=∑xx⋅Pr[X=x](连续)E[X]:=∫∞−∞xfX(x)dx 其中 fX(⋅) 是随机变量 X 的概率密度函数。

若 X 为任意整数随机变量,则 E[X]=∑x≥1(Pr[X≥x]−Pr[X≤−x]) 这个结论可以通过 Pr[X=x]=Pr[X≥x]−Pr[X≥x+1] 这个等价代换来证明。

1.6 条件期望

事件 A 发生的情况下随机变量 X 的条件期望为: E[X∣A]:=∑xx⋅Pr[X=x∣A]=∑xx⋅Pr[X=x∧A]Pr[A]=∑xx⋅Pr[{ω∈A∣X(ω)=x}]Pr[A]

1.7(离散变量的)全期望展开

对于任意事件 A(或随机变量 A),下面两个式子成立: E[X]=E[X∣A]⋅Pr[A]+E[X∣¬A]⋅Pr[¬A]E[X]=∑aE[X∣A=a]⋅Pr[A=a]

1.8 联合概率(以连续变量为例)

-

联合分布函数:设二元随机变量 (X,Y) 的分布函数为 CDF(x,y),其联合概率密度函数为 f(x,y),则有 CDF(x,y)=Pr[X≤x,Y≤y]=∫x−∞∫y−∞f(u,v)dudvCDF(∞,∞)=1

-

边缘分布函数: CDFX(x)=Pr[X≤x]=∫x−∞∫∞−∞f(u,v)dudv=CDF(x,∞)CDFY(y)=Pr[Y≤y]=∫∞−∞∫y−∞f(u,v)dudv=CDF(∞,y)

-

边缘密度函数: fX(x)=limΔx→0CDFX(x+Δx)−CDFX(x)Δx=limΔx→0∫x+Δxx∫∞−∞f(u,v)dudvΔx=∫∞−∞f(x,v)dv 同理有 fY(y)=∫∞−∞f(u,y)du

-

条件密度函数:在 Y=y 的条件下,X 的条件密度函数记为 fX|Y(x∣y),则

fX|Y(x∣y):=limΔx→0Pr[x≤X≤x+Δx∣Y=y]Δx=limΔx→0limΔy→0Pr[x≤X≤x+Δx,y≤Y≤y+Δy]ΔxPr[y≤Y≤y+Δy]=limΔx→0limΔy→0∫x+Δxx∫y+Δyyf(u,v)dudvΔx∫∞−∞∫y+Δyydudv=∫y+Δyyf(x,v)dv∫∞−∞∫y+Δyydudv=∫y+Δyyf(x,v)dvΔy∫∞−∞∫y+ΔyydudvΔy=f(x,y)∫∞−∞f(u,y)du=f(x,y)fY(y)

-

联合概率密度:由上可知,对于两个连续的随机变量 X 和 Y,它们的联合概率密度为 f(x,y)=fX|Y(x∣y)fY(y)=fY|X(y∣x)fX(x)

-

条件期望: EX[X∣Y=y]:=∫∞−∞xfX|Y(x∣y)dx=∫∞−∞xf(x,y)fY(y)dx

且有

EY[EX[X∣Y]]=∫∞−∞EX[X∣Y]fY(y)dy=∫∞−∞∫∞−∞xfX|Y(x∣y)dxfY(y)dy=∫∞−∞x∫∞−∞fX|Y(x∣y)fY(y)dydx=∫∞−∞x[∫∞−∞f(x,y)dy]dx=∫∞−∞x[fX(x)]dx=EX[X] 这就是**(连续变量的)全期望展开**。同理可得:EX[EY[Y∣X]]=EY[Y]。

1.9 随机变量的独立性及其特征

-

随机变量的独立性(由事件的独立性引申而来): 如果对于任意的 x 和 y,事件 {ω∈Ω∣X(ω)=x} 和事件 {ω∈Ω∣Y(ω)=y} 是独立的,即 Pr[X=x∧Y=y]=Pr[X=x]⋅Pr[Y=y]

或

Pr[X=x∣Y=y]=Pr[X=x] 对任意的 x 和 y 恒成立,则称随机变量 X 和 Y 独立。这意味着,知道其中一个随机变量的取值不会对知道另一个随机变量的分布有任何帮助。

一组随机变量 X1,X2,...,Xn 相互独立当且仅当对于任意的 x1,x2,...,xn 有 Pr[n⋀i=1(Xi=xi)]=n∏i=1Pr[Xi=xi]

-

对期望的影响(以离散变量为例):如果定义在实数域的随机变量 X 和 Y 独立,则 E[X⋅Y]=∑x∑yPr[X=x,Y=y]=∑xxPr[X=x]⋅∑yyPr[Y=y]=E[X]⋅E[Y] 且对于任意给定函数 f,都有 f(X) 和 f(Y) 独立。反之不一定成立。

同理,如果定义在实数域的一组随机变量 X1,X2,...,Xn 相互独立,则 E[n∏i=1Xi]=n∏i=1E[Xi] 且对于任意给定函数 f,都有 f(X1),f(X2),...,f(Xn) 相互独立。反之不一定成立。

不论随机变量 X1,X2,...,Xn 是否独立,总有 E[n∑i=1aiXi]=∑x1,...,xnaixiPr[Xi=xi]=n∑i=1aiE[Xi]

2 泊松分布与指数分布

-

泊松分布:将一个时间段切分成等大小的时间片,每个时间片内事件只有 “发生” 和“不发生”两种情形(每个时间片内是伯努利分布,多个时间片是二项分布),泊松分布的随机变量就是 该二项分布在时间片个数趋于无穷时事件发生的个数。

将该随机变量记为 X,事件发生的概率为 p,则 P(X=k)=limn→∞(nk)pk(1−p)1−k。因为二项分布的期望值 E[X]=np,不妨记为 μ,则 p=μn,带回上式可得即可得 P(X=k)=limn→∞μkk!e−μ 这就是泊松分布的概率密度函数。

-

指数分布:若某事件在给定时间段内发生的次数服从泊松分布,那么指数分布的随机变量就是 该事件前后两次发生的时间间隔。引入时间参数 t,令 μ=λt,t=1 表示整个时间段,t=0.5 表示半个时间段,则 P(X=k)=P(X=k,t)=limn→∞(λt)kk!e−λt 令随机变量 Y 是 两个事件发生的时间间隔,则 Y>t 的概率等价于 t 时间内事件发生 0 次的概率,即 PY(Y>t)=PX(X=0,t)=e−λt 所以有 PY(Y≤t)=1−e−λt 这就是指数分布的概率密度函数。

-

无记忆性:指数分布(连续)和几何分布(离散)具有无记忆性。即 P(X>s+t∣X>s)=P(X>t) 这意味着,事件发生的概率并不会伴随着等待的时间变长而增加,事件第 n+1 次发生与第 1 次发生概率一样,不会因为已经发生了 n 次而改变。这一结论与人类的本能 “赌徒心理” 正好相反。比特币基于 PoW 的共识机制正是利用了这种无记忆性。在任意时刻加入对 nonce 的猜测,都不会改变猜中的概率。这就给予了矿工们 “与算力成比例的” 优势。

3 使用概率论解决实际问题

3.1 问题 1

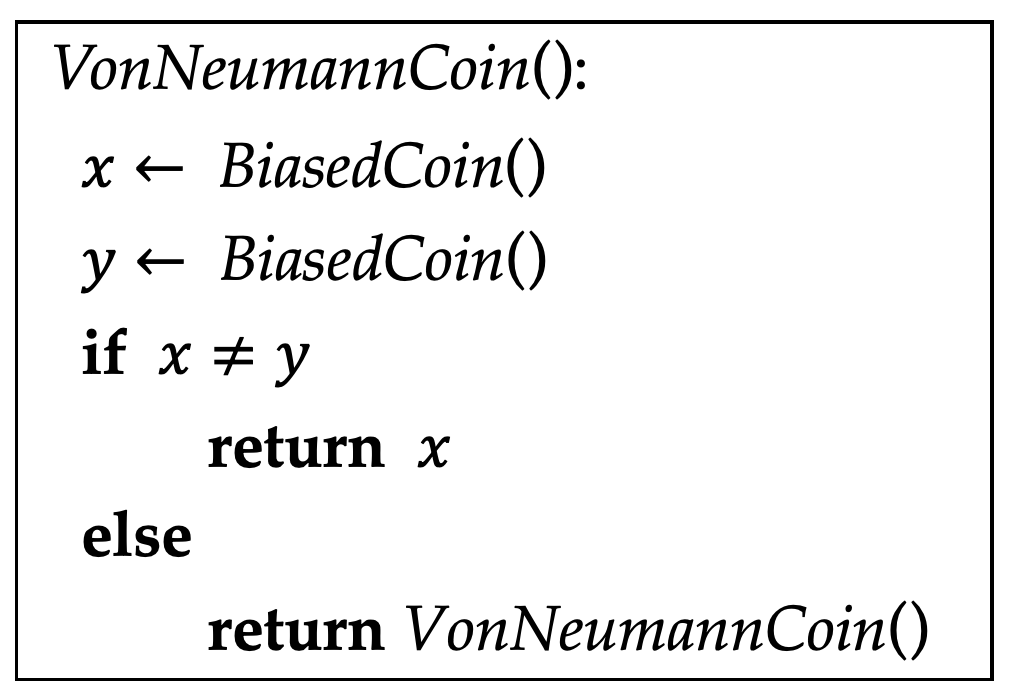

对应任意硬币(可能被做假,不妨假设正面落下的概率为 p,反面落下的概率为 q,p+q=1),试证明:通过如下方法总能产生公平的抛硬币效果,并求解 BiasedCoin() 的期望调用次数。

求解:若停机,则必然有 x≠y,所以 Pr[x=0∧y=1∣x≠y]=Pr[x=1∧y=0∣x≠y]=pq2pq=12 这里运用了 x 和 y 相互独立。

令随机变量 T 为 BiasedCoin() 的调用次数,则

E[T]=E[T∣x≠y]⋅Pr[x≠y]+E[T∣x=y]⋅Pr[x=y]

其中,Pr[x≠y]=2pq,E[x≠y]=2(因为一轮就结束了,只运行了两次)。此外有 Pr[x=y]=1−2pq,E[T∣x=y]=2+E[T](递归调用),联立可解得 E[T]=1pq。

3.2 问题 2

假设有 n 种不同的卡,每次买一包干脆面可以抽出一种卡。假设买了 n 包干脆面,可以抽出多少张不同的卡?为了收集到全部种类的卡,至少要买几包干脆面?

求解:对应第 i 种卡,定义随机变量 Xi∈{0,1} 表示我们是否拥有它。定义随机变量 X 表示我们拥有的、不同种类的卡的个数。显然有 X=∑iXi。 所以 E[X]=∑iE[Xi]=∑iEPr[Xi=1]。

在 n 次购买中,∀i,我们没有抽到第 i 种卡的概率为 Pr[Xi=0]=(1−1n)n≈1e(这是因为每次购买抽出第 i 种卡的概率服从独立同分布),所以 E[X]≈ne≈0.632n。

设 T(n) 为收集了 n 种卡所购买的干脆面的包数。将购买行为划分为 n 个阶段,第 i 个阶段在抽到第 i 种卡之后停止。用 Ti(n) 表示第 i 个阶段购买的干脆面的包数。 则 T(n)=∑ni=1Ti(n)。在第 i 个阶段,抽到一张新卡的概率为 n−(i−1)n,此时 Ti(n) 实际上是一个几何分布的随机变量,根据几何分布的期望可知 E[Ti(n)]=nn−i+1,所以 E[T(n)]=n∑j=1nj=n(1+12+13+...+1n) 后面这个几何级数满足 ln(n+1)≤∑nj=11j≤lnn+1(借助每段函数 1j 的上下界函数的积分来计算),所以可得结论:至少要买 Θ(nlnn) 包。

转载申请

本作品采用 知识共享署名 4.0 国际许可协议 进行许可,转载时请注明原文链接。您必须给出适当的署名,并标明是否对本文作了修改。